Technologie

Déficients visuels : une bague électronique en guise de canne ?

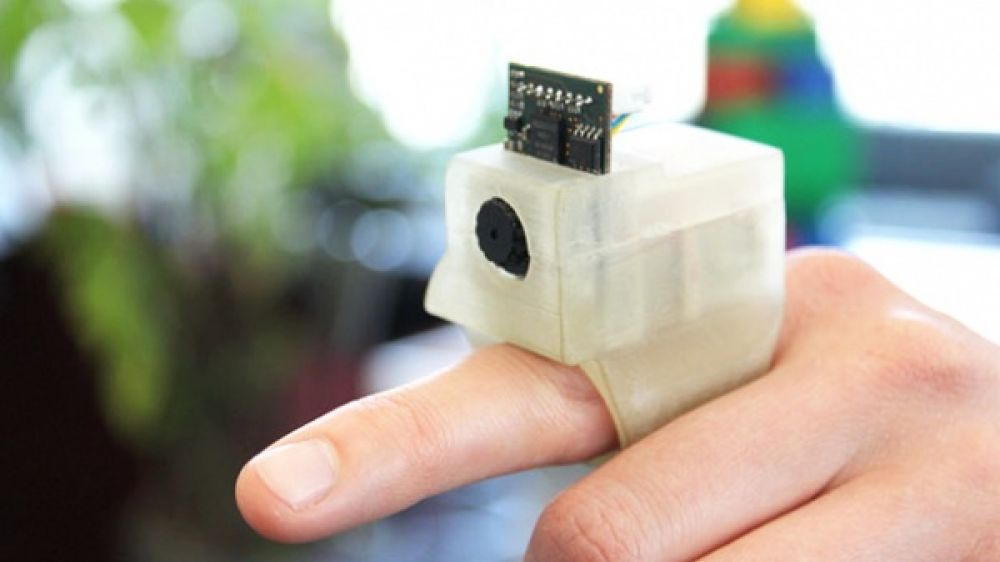

Des chercheurs américains ont mis au point une bague équipée d’une microcaméra, qui sert à prendre des photos d’un objet pour en obtenir une description auditive. Un système qui pourrait faciliter les déplacements des personnes non voyantes.

Pointer du doigt un objet pour savoir ce que c'est, sa couleur ou son prix : voilà ce qu'est capable de faire EyeRing - littéralement « bague oeil ». Ce prototype conçu par des chercheurs du Massachusetts Institute of Technology ( MIT) est destiné à aider les personnes souffrant de déficience visuelle.

Concentré de technologie

Le principe est simple. L'usager porte à l'index la bague qu'il pointe vers un objet, une porte ou encore un passage piéton. D'une pression sur un bouton, l'anneau muni d'une caméra intégrée prend une photo. Celle-ci est transmise à un smartphone par une liaison Bluetooth pour y être analysée par une application de traitement d'image, qui va, en retour, décrire vocalement ce qu'elle voit et indiquer la distance qui sépare l'usager de l'objet. « Le désir de remplacer le sens de la vue pour une personne non voyante ou d’améliorer celui d’une personne valide a eu une forte influence sur la conception d’EyeRing », expliquent les chercheurs dans leur publication technique. Encore plus bluffant, il suffit de prononcer les mots-clés « couleur », « étiquette » ou « monnaie », pour que la bague reconnaisse les couleurs de l'objet pointé, décrypte un prix ou identifie un billet de banque. Dans la vidéo de démonstration ci-dessous, un homme non voyant entre dans un centre commercial et achète un vêtement grâce à l' EyeRing .

Un œil vers le tourisme

EyeRing s'adresse également aux personnes valides. Parmi les développements envisagés, figurent l’assistance à la navigation et la traduction, pour aider les touristes à se repérer. « Même avec des applications de réalité augmentée, l’interface utilisateur pour la navigation pédestre n’est pas assez ergonomique, poursuivent les concepteurs d’EyeRing. Notre projet d’application repose sur une gestuelle bien plus naturelle, comme de pointer en direction d’un paysage en demandant « Qu’est-ce que c’est ? » et d’entendre le réponse ».

Pour le moment, le système fonctionne avec un smartphone sous Android 2.2 et une application iOS est en cours de développement. Les chercheurs du MIT vont maintenant s’atteler à valider leurs données à plus grande échelle et perfectionner leur prototype pour le rendre compatible avec de nouveaux capteurs (gyroscope, infrarouge, laser etc.). Encore quelques années de patience avant de pouvoir vous passer la bague au doigt !